Punti chiave

L’Intelligenza Artificiale può essere classificata in IA analitica, ispirata all’essere umano e umanizzata a seconda dei tipi di intelligenza che esprime, intelligenza cognitiva, emotiva e sociale o in intelligenza artificiale ristretta, generale e super a seconda del suo stadio evolutivo.

Tuttavia, ciò che tutti questi tipi hanno in comune è che quando l’IA raggiunge un uso diffuso, spesso non viene più considerata come tale. Questo fenomeno è descritto come l’effetto IA, che si verifica quando gli osservatori svalutano il comportamento di un programma IA sostenendo che non si tratta di vera intelligenza. Come disse una volta lo scrittore di fantascienza britannico Arthur Clarke: “Ogni tecnologia sufficientemente avanzata è indistinguibile dalla magia“. Tuttavia, quando si comprende la tecnologia, la magia scompare.

A intervalli regolari fin dagli anni ’50, gli esperti hanno previsto che ci vorranno solo pochi anni prima di raggiungere l’Intelligenza Artificiale Generale – sistemi che mostrano un comportamento indistinguibile da quello umano in tutti gli aspetti e che hanno intelligenza cognitiva, emotiva e sociale. Solo il tempo dirà se ciò accadrà effettivamente. Ma per comprendere meglio ciò che è fattibile, è possibile guardare all’IA da due angolazioni: la strada già percorsa e ciò che ancora ci attende. In questo editoriale, cerchiamo di fare proprio questo. Iniziamo esaminando il passato dell’IA per vedere quanto sia evoluta questa area utilizzando l’analogia delle quattro stagioni (primavera, estate, autunno e inverno), poi il presente per capire quali sfide le aziende affrontano oggi e infine il futuro per aiutare tutti a prepararsi alle sfide che ci attendono.

La Nascita dell’AI

Sebbene sia difficile individuare una data precisa, le radici dell’Intelligenza Artificiale possono probabilmente essere fatte risalire agli anni ’40, nello specifico al 1942, quando lo scrittore di fantascienza americano Isaac Asimov pubblicò il suo breve racconto “Runaround”. La trama di Runaround, una storia su un robot sviluppato dagli ingegneri Gregory Powell e Mike Donovan, ruota attorno alle Tre Leggi della Robotica:

- Un robot non può recar danno a un essere umano né può permettere che, a causa del suo mancato intervento, un essere umano riceva danno.

- Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non vadano in contrasto alla Prima Legge.

- Un robot deve proteggere la propria esistenza, purché la salvaguardia di essa non contrasti con la Prima o con la Seconda Legge.

Il lavoro di Asimov ha ispirato generazioni di scienziati nel campo della robotica, dell’IA e dell’informatica, tra cui il cognitivista americano Marvin Minsky che in seguito ha co-fondato il laboratorio AI del MIT.

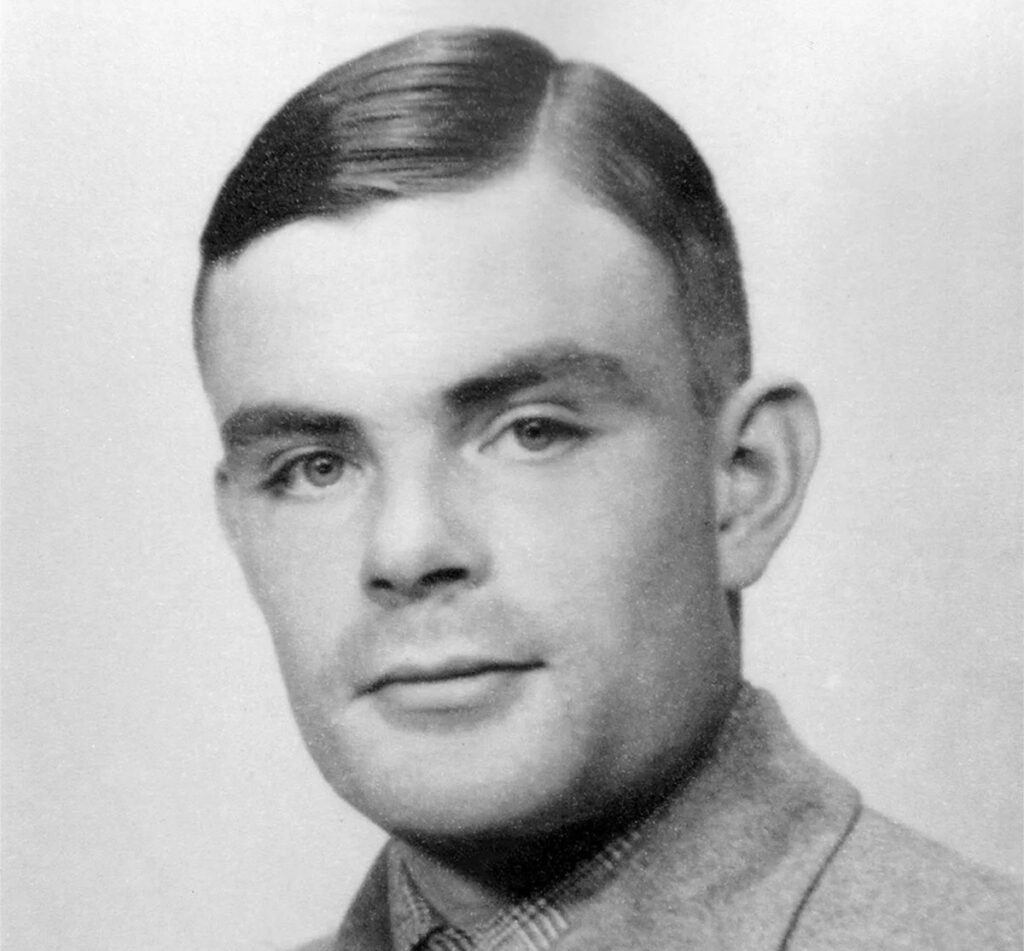

Più o meno nello stesso periodo, ma a più di 5.000 km di distanza, il matematico inglese Alan Turing lavorò su questioni molto meno fittizie e sviluppò una macchina per decifrare codici per il governo britannico, con lo scopo di decifrare il codice Enigma usato dall’esercito tedesco nella seconda guerra mondiale.

La macchina di Turing aveva un peso di circa una tonnellata, è generalmente considerato il primo computer elettromeccanico funzionante. Il modo potente in cui la macchina è stata in grado di decifrare il codice Enigma, un compito precedentemente impossibile anche ai migliori matematici umani, ha fatto meravigliare Turing stesso sull’intelligenza di tali macchine. Nel 1950 pubblicò il suo fondamentale articolo “Computing Machinery and Intelligence” in cui descriveva come creare macchine intelligenti e in particolare come testare la loro intelligenza.

Il test di Turing è ancora oggi considerato un punto di riferimento per identificare l’intelligenza di un sistema artificiale, se un essere umano sta interagendo con un altro essere umano e una macchina e non è in grado di distinguere la macchina dall’umano, allora la macchina si dice intelligente.

La parola Intelligenza Artificiale fu poi coniata ufficialmente circa sei anni dopo, quando nel 1956 Marvin Minsky e John McCarthy, un informatico a Stanford, ospitarono il Dartmouth Summer Research Project on Artificial Intelligence (DSRPAI) della durata di circa otto settimane presso il Dartmouth College di New Hampshire. Questo seminario, che segna l’inizio della primavera dell’IA ed è stato finanziato dalla Fondazione Rockefeller, ha riunito coloro che in seguito sarebbero stati considerati i padri fondatori dell’IA.

Tra i partecipanti c’erano lo scienziato informatico Nathaniel Rochester, che in seguito progettò l’IBM 701, il primo computer scientifico commerciale, e il matematico Claude Shannon, che fondò la teoria dell’informazione. L’obiettivo di DSRPAI era quello di riunire ricercatori di vari campi al fine di creare una nuova area di ricerca finalizzata alla costruzione di macchine in grado di simulare l’intelligenza umana.

Gli alti e bassi dell’IA

La Conferenza di Dartmouth fu seguita da un periodo di quasi due decenni che vide significativi successi nel campo dell’IA. Un esempio è il famoso programma informatico ELIZA, creato tra il 1964 e il 1966 da Joseph Weizenbaum al MIT. ELIZA era uno strumento di elaborazione del linguaggio naturale capace di simulare una conversazione con un essere umano ed è stato uno dei primi programmi in grado di tentare di superare il Turing Test. Un’altra storia di successo dei primi giorni dell’IA fu il programma General Problem Solver, sviluppato dal premio Nobel Herbert Simon e dai ricercatori della RAND Corporation Cliff Shaw e Allen Newell, che era in grado di risolvere automaticamente determinati tipi di problemi semplici, come la Torre di Hanoi. A seguito di queste storie di successo ispiratrici, furono dati cospicui finanziamenti alla ricerca sull’IA, portando a sempre più progetti. Nel 1970, Marvin Minsky rilasciò un’intervista alla rivista Life in cui affermava che si sarebbe potuto sviluppare una macchina con l’intelligenza generale di un essere umano medio entro tre o otto anni.

Tuttavia, sfortunatamente, non fu così. Solo tre anni dopo, nel 1973, il Congresso degli Stati Uniti iniziò a criticare fortemente la spesa elevata per la ricerca sull’Intelligenza Artificiale. Lo stesso anno, il matematico britannico James Lighthill pubblicò una relazione commissionata dal Consiglio di Ricerca Scientifica britannico in cui mise in discussione le prospettive ottimistiche degli studiosi di Intelligenza Artificiale. Lighthill affermò che le macchine avrebbero raggiunto solo il livello di un “amatore esperto” in giochi come gli scacchi e che il ragionamento di buon senso sarebbe sempre stato al di là delle loro capacità.

In risposta, il governo britannico interruppe il sostegno alla ricerca sull’Intelligenza Artificiale in tutte le università tranne tre (Edimburgo, Sussex ed Essex) e presto anche il governo degli Stati Uniti seguì l’esempio britannico. Questo periodo iniziò l’Inverno dell’Intelligenza Artificiale. E sebbene il governo giapponese abbia iniziato a finanziare pesantemente la ricerca sull’Intelligenza Artificiale negli anni ’80, a cui il DARPA degli Stati Uniti ha risposto con un aumento dei finanziamenti, non sono stati fatti ulteriori progressi nei successivi anni.

Gli sviluppi dell’Intelligenza Artificiale

Uno dei motivi dell’iniziale mancanza di progressi nel campo dell’intelligenza artificiale e del fatto che la realtà è scesa bruscamente rispetto alle aspettative risiede nel modo specifico in cui i primi sistemi come ELIZA e il General Problem Solver hanno cercato di replicare l’intelligenza umana. Nello specifico, erano tutti Sistemi Esperti, ovvero raccolte di regole che presuppongono che l’intelligenza umana possa essere formalizzata e ricostruita in un approccio dall’alto verso il basso come una serie di affermazioni “se-allora”, che si prestano a tale formalizzazione.

Ad esempio, il programma di gioco degli scacchi Deep Blue di IBM, che nel 1997 è stato in grado di battere il campione del mondo Gary Kasparov secondo quanto riferito, Deep Blue è stato in grado di elaborare 200 milioni di possibili mosse al secondo e di determinare la mossa successiva ottimale guardando 20 mosse avanti attraverso l’uso di un metodo chiamato ricerca ad albero.

Ad esempio, un Sistema Esperto non può essere facilmente addestrato a riconoscere i volti o persino a distinguere tra un’immagine che mostra un muffin e una che mostra un Chihuahua. Per tali compiti è necessario che un sistema sia in grado di interpretare correttamente i dati esterni, per imparare da tali dati e utilizzare tali apprendimenti per raggiungere obiettivi e compiti specifici attraverso un adattamento flessibile, caratteristiche che definiscono l’IA. Poiché i Sistemi Esperti non possiedono queste caratteristiche, tecnicamente parlando non sono vere IA. I metodi statistici per ottenere una vera intelligenza artificiale sono stati discussi già negli anni ’40, quando lo psicologo canadese Donald Hebb sviluppò una teoria dell’apprendimento nota come Hebbian Learning che replica il processo dei neuroni nel cervello umano.

Tuttavia, questo lavoro è rimasto fermo nel 1969, quando Marvin Minsky e Seymour Papert hanno dimostrato che i computer non avevano una potenza di elaborazione sufficiente per gestire il lavoro richiesto da tali reti neurali artificiali. Le reti neurali artificiali sono tornate alla ribalta sotto forma di Deep Learning quando nel 2015 AlphaGo , un programma sviluppato da Google, è riuscito a battere il campione del mondo nel gioco da tavolo Go.

Oggi le reti neurali artificiali e il Deep Learning costituiscono la base della maggior parte delle applicazioni che conosciamo sotto l’etichetta di IA. Sono la base degli algoritmi di riconoscimento delle immagini utilizzati da Facebook, algoritmi di riconoscimento vocale che alimentano altoparlanti intelligenti e auto a guida autonoma. Questa raccolta dei frutti dei progressi statistici passati è il periodo di IA Fall, in cui ci troviamo oggi.

Il futuro dell’Intelligenza Artificiale

Il fatto che nel prossimo futuro i sistemi di intelligenza artificiale faranno sempre più parte della nostra vita quotidiana solleva la questione se è necessaria la regolamentazione e, in tal caso, in quale forma. Sebbene l’IA sia nell’obiettivo di essenza e senza pregiudizio, non significa che i sistemi basati sull’intelligenza artificiale non possano essere distorti. In effetti, a causa del suo stesso natura, qualsiasi distorsione presente nei dati di input utilizzati per addestrare un sistema di IA persiste e può persino essere amplificata.

La ricerca ha, ad esempio, dimostrato che i sensori utilizzati nelle auto a guida autonoma sono migliori nel rilevare tonalità della pelle più chiare rispetto a quelle più scure a causa del tipo di immagini utilizzate per addestrare tali algoritmi o che i sistemi di supporto decisionale utilizzati dai giudici possono essere di parte razziale poiché si basano sull’analisi di sentenze passate. Invece di cercare di regolamentare l’intelligenza artificiale stessa, il modo migliore per evitare tali errori è probabilmente quello di sviluppare requisiti comunemente accettati per quanto riguarda l’addestramento e il test degli algoritmi di intelligenza artificiale, possibilmente in combinazione con qualche forma di garanzia, simile ai protocolli di test sui consumatori e sulla sicurezza utilizzati per i test fisici prodotti.

Ciò consentirebbe una regolamentazione stabile anche se gli aspetti tecnici dei sistemi di IA si evolvessero nel tempo. Una questione correlata è quella della responsabilità delle aziende per gli errori dei loro algoritmi o anche la necessità di un codice morale degli ingegneri di intelligenza artificiale, simile a quello su cui giurano avvocati o medici. Ciò che tali regole, tuttavia, non possono evitare è l’hacking deliberato dei sistemi di intelligenza artificiale, l’uso indesiderato di tali sistemi per il microtargeting basato sui tratti della personalità o la generazione di notizie false. Ciò che rende le cose ancora più complicate è che il Deep Learning, una tecnica chiave utilizzata dalla maggior parte dei sistemi di intelligenza artificiale, è intrinsecamente una scatola nera. Sebbene sia semplice valutare la qualità dell’output generato da tali sistemi, ad esempio, la quota di immagini correttamente classificate, il processo utilizzato per farlo rimane in gran parte opaco.

Tale opacità può essere intenzionale, ad esempio, se una società vuole mantenere segreto un algoritmo, a causa dell’analfabetismo tecnico o correlata alla scala dell’applicazione. Sebbene ciò possa essere accettabile in alcuni casi, può esserlo meno in altri. Ad esempio, a poche persone potrebbe interessare il modo in cui Facebook identifica chi taggare in una determinata immagine. Ma quando i sistemi di intelligenza artificiale vengono utilizzati per fornire suggerimenti diagnostici per il cancro della pelle sulla base dell’analisi automatica delle immagini, capire come tali raccomandazioni sono state derivate diventa fondamentale.

Conclusioni

Nessuno sa se l’intelligenza artificiale ci consentirà di migliorare la nostra intelligenza, come pensa Raymond Kurzweil di Google, o se alla fine ci guiderà nella terza guerra mondiale, una preoccupazione sollevata da Elon Musk. Tuttavia, tutti concordano sul fatto che si tradurrà in sfide etiche, legali e filosofiche uniche che dovranno essere affrontate.

Per decenni, l’etica ha affrontato il problema del carrello, un esperimento mentale in cui una persona immaginaria deve scegliere tra inattività porta alla morte di molti e l’attività che porta alla morte di pochi. In un mondo di auto a guida autonoma, questi problemi diventeranno scelte effettive che le macchine e, per estensione, i loro programmatori umani dovranno fare.

In risposta, le richieste di regolamentazione sono state numerose, anche da parte di attori importanti come Mark Zuckerberg. Ma come possiamo regolamentare una tecnologia che è in continua evoluzione da sola e che pochi esperti, per non parlare dei politici, comprendono appieno? Come possiamo superare la sfida di essere sufficientemente ampi da consentire evoluzioni future in questo mondo in rapido movimento e sufficientemente precisi da evitare che tutto venga considerato come IA?

Una soluzione può essere seguire l’approccio del giudice della Corte Suprema degli Stati Uniti Potter Stewart che nel 1964 definì l’oscenità dicendo: “Lo so quando lo vedo”. Questo ci riporta all’effetto AI menzionato in precedenza, che ora tendiamo rapidamente ad accettare come normale fosse visto come straordinario. Esistono oggi dozzine di app diverse che consentono a un utente di giocare a scacchi contro il suo telefono. Giocare a scacchi contro una macchina – e perdere con quasi certezza – è diventata una cosa che non vale nemmeno la pena menzionare. Presumibilmente, Garry Kasparov aveva una visione completamente diversa su questo argomento nel 1997, poco più di 20 anni fa.

Biografie dell’autore

Michael Haenlein è professore presieduto dal Big Data Research Center e decano associato dell’Executive PhD Program presso la ESCP Europe Business School (e-mail: [email protected]). Andreas Kaplan, professore e preside della ESCP Europe Business School di Berlino, è tra i primi 50 autori di business e management in tutto il mondo (e-mail: [email protected]).

Il presente testo è una libera traduzione del A Brief History of Artificial Intelligence: On the Past, Present, and Future of Artificial Intelligence